英偉達老板黃仁勛最近感覺自己壓力山大,因為全球的AI芯片壓力都壓在了他的肩膀上。

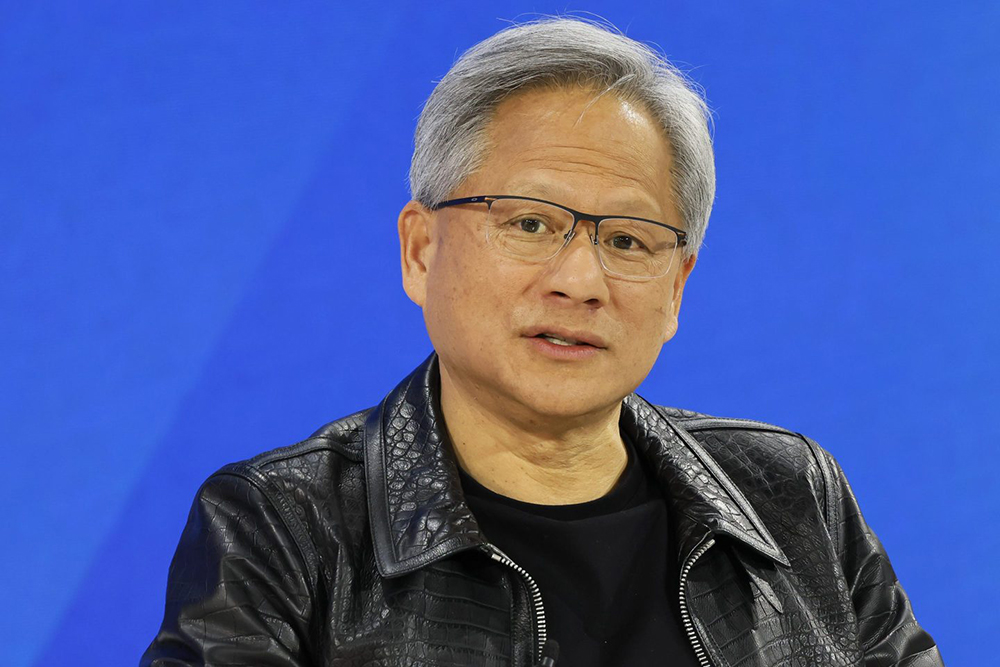

英偉達已經是一家市值達2.9萬億美元的半導體巨頭了。作為英偉達的創始人和CEO,黃仁勛在上周三接受采訪時談到了他當前面臨的壓力,特別是能夠運行最新AI系統(比如GPT-4以后的最新大模型)的芯片供給嚴重不足的問題。

現在,英偉達的所有客戶都在虎視眈眈地盯著他們——他們每從英偉達拿到一枚AI芯片,對他們來說都是一種競爭優勢,因為他們的對手就少拿到了一枚。而黃仁勛的工作就是走好這根“鋼絲”,盡可能平衡供給分配,以免危及客戶關系。

他在高盛舉辦的一次科技會議上表示:“不管是我們的組件,還是我們的技術、基礎設施和軟件,在交付的時候,大家都是很情緒化的,因為這直接影響到了他們的收入,直接影響到了他們的競爭力。”

至于黃仁勛說的“情緒化”究竟是怎么一種情緒,我們還不清楚。因為當我們提出采訪請求時,英偉達拒絕就此事發表進一步評論。但有一件事是肯定的,客戶對英偉達的芯片存在大量需求,尤其是三個主要的超級云服務提供商——微軟、谷歌和亞馬遜。而且除了英偉達之外,目前也沒有別人能滿足他們的需求。英偉達已經控制了90%的AI芯片市場。

AI賽道上,速度就是一切

作為英偉達的創始人和CEO,黃仁勛會親自對接重要客戶。比如今年4月,他就向OpenAI的首席執行官山姆·阿爾特曼和總裁格雷格·布羅克曼親手交付了全球第一臺DGX服務器,該服務器搭載了升級版的Hopper系列AI訓練芯片——也就是最新款的H200。

為了在AI賽道上阻擊OpenAI,埃隆·馬斯克近日透露,他計劃在接下來的幾個月采購5萬片H200芯片,來讓設在孟菲斯的xAI訓練集群的算力增加一倍。目前,他的Grok-3 AI大模型正在那里接受訓練。

馬斯克近日在社交媒體上發帖稱:“我們的根本競爭力取決于能否比其他任何AI公司更快,這也是唯一的追趕途徑。如果我們的命運取決于能否做一家最快的公司,那我們就必須把自己的手放在方向盤上,而不是坐在后排瞎指揮。”

這也是為什么馬斯克寧可冒著激怒特斯拉股東的風險,也要將英偉達的芯片分配給xAI,因為這些芯片本應被用于訓練特斯拉的自動駕駛軟件系統FSD。另外,xAI之所以能在短短三個月里上線全球 最大的單個計算集群,也與馬斯克集中調用大量AI芯片不無關系。該計算集群由10萬個英偉達H100 GPU芯片提供支持。

馬斯克對于英偉達是個什么級別的客戶,我們不得而知。但據英偉達透露,今年第二季度,僅四個數據中心客戶,就貢獻了它當季接近一半的營收。

黃仁勛在上周三的高盛會議上表示:“如果我們能滿足每個人的需求,這種情緒就會消失,但這種情緒是很強的、很緊張的。我們肩上擔負著很多責任,我們也會盡力做到最好。”

供應緊張將有所緩解

黃仁勛并不是在開玩笑。上個月底,英偉達公布了第二季度財報。Wedbush公司科技分析師丹·艾夫斯稱其為“近年來最重要的科技公司財報”。

投資者和客戶最關心的一個核心問題是,繼Hopper之后的下一款人工智能芯片Blackwell能否按計劃順利推出,因為之前有報道表示Blackwell可能會跳票。但從財報上看,這個問題已經得到了解決。

在投資者電話會議上,黃仁勛證實,英偉達有必要對芯片的高精度光刻掩膜板的設計進行修改,以便提高每片硅晶上的芯片產量。同時他堅稱,在今年第四財季結束前(也就是在明年1月底前),他仍然能夠出貨價值數十億美元的Blackwell芯片。

與英特爾或德儀這種集成設備廠商不同的是,英偉達所有半導體生產都外包給了專門的公司,而且主要是臺積電。臺積電在芯片生產方面處于行業領先地位。

但是由于它的產能主要依賴臺積電,這也意味著英偉達短期內無法迅速提高產能來回應需求的激增。更何況這些AI芯片的工藝極其復雜,需要長達數月的復雜工藝才能制造出來。

上個月月底,黃仁勛在接受彭博電視采訪時表示,目前AI芯片供給緊張的情況正在得到緩解。

他在采訪中表示:“我們預計第三季度的供應量將超過第二季度,第四季度的供應量將超過第三季度,明年第一季度的供應量又將超過第四季度。所以我認為,我們明年的供應狀況將比今年有很大改善。”

如果這是真的,那么在不久的將來,黃仁勛終于可以少承受一些來自那些情緒激動的客戶的壓力了。(財富中文網)

譯者:樸成奎

英偉達老板黃仁勛最近感覺自己壓力山大,因為全球的AI芯片壓力都壓在了他的肩膀上。

英偉達已經是一家市值達2.9萬億美元的半導體巨頭了。作為英偉達的創始人和CEO,黃仁勛在上周三接受采訪時談到了他當前面臨的壓力,特別是能夠運行最新AI系統(比如GPT-4以后的最新大模型)的芯片供給嚴重不足的問題。

現在,英偉達的所有客戶都在虎視眈眈地盯著他們——他們每從英偉達拿到一枚AI芯片,對他們來說都是一種競爭優勢,因為他們的對手就少拿到了一枚。而黃仁勛的工作就是走好這根“鋼絲”,盡可能平衡供給分配,以免危及客戶關系。

他在高盛舉辦的一次科技會議上表示:“不管是我們的組件,還是我們的技術、基礎設施和軟件,在交付的時候,大家都是很情緒化的,因為這直接影響到了他們的收入,直接影響到了他們的競爭力。”

至于黃仁勛說的“情緒化”究竟是怎么一種情緒,我們還不清楚。因為當我們提出采訪請求時,英偉達拒絕就此事發表進一步評論。但有一件事是肯定的,客戶對英偉達的芯片存在大量需求,尤其是三個主要的超級云服務提供商——微軟、谷歌和亞馬遜。而且除了英偉達之外,目前也沒有別人能滿足他們的需求。英偉達已經控制了90%的AI芯片市場。

AI賽道上,速度就是一切

作為英偉達的創始人和CEO,黃仁勛會親自對接重要客戶。比如今年4月,他就向OpenAI的首席執行官山姆·阿爾特曼和總裁格雷格·布羅克曼親手交付了全球第一臺DGX服務器,該服務器搭載了升級版的Hopper系列AI訓練芯片——也就是最新款的H200。

為了在AI賽道上阻擊OpenAI,埃隆·馬斯克近日透露,他計劃在接下來的幾個月采購5萬片H200芯片,來讓設在孟菲斯的xAI訓練集群的算力增加一倍。目前,他的Grok-3 AI大模型正在那里接受訓練。

馬斯克近日在社交媒體上發帖稱:“我們的根本競爭力取決于能否比其他任何AI公司更快,這也是唯一的追趕途徑。如果我們的命運取決于能否做一家最快的公司,那我們就必須把自己的手放在方向盤上,而不是坐在后排瞎指揮。”

這也是為什么馬斯克寧可冒著激怒特斯拉股東的風險,也要將英偉達的芯片分配給xAI,因為這些芯片本應被用于訓練特斯拉的自動駕駛軟件系統FSD。另外,xAI之所以能在短短三個月里上線全球 最大的單個計算集群,也與馬斯克集中調用大量AI芯片不無關系。該計算集群由10萬個英偉達H100 GPU芯片提供支持。

馬斯克對于英偉達是個什么級別的客戶,我們不得而知。但據英偉達透露,今年第二季度,僅四個數據中心客戶,就貢獻了它當季接近一半的營收。

黃仁勛在上周三的高盛會議上表示:“如果我們能滿足每個人的需求,這種情緒就會消失,但這種情緒是很強的、很緊張的。我們肩上擔負著很多責任,我們也會盡力做到最好。”

供應緊張將有所緩解

黃仁勛并不是在開玩笑。上個月底,英偉達公布了第二季度財報。Wedbush公司科技分析師丹·艾夫斯稱其為“近年來最重要的科技公司財報”。

投資者和客戶最關心的一個核心問題是,繼Hopper之后的下一款人工智能芯片Blackwell能否按計劃順利推出,因為之前有報道表示Blackwell可能會跳票。但從財報上看,這個問題已經得到了解決。

在投資者電話會議上,黃仁勛證實,英偉達有必要對芯片的高精度光刻掩膜板的設計進行修改,以便提高每片硅晶上的芯片產量。同時他堅稱,在今年第四財季結束前(也就是在明年1月底前),他仍然能夠出貨價值數十億美元的Blackwell芯片。

與英特爾或德儀這種集成設備廠商不同的是,英偉達所有半導體生產都外包給了專門的公司,而且主要是臺積電。臺積電在芯片生產方面處于行業領先地位。

但是由于它的產能主要依賴臺積電,這也意味著英偉達短期內無法迅速提高產能來回應需求的激增。更何況這些AI芯片的工藝極其復雜,需要長達數月的復雜工藝才能制造出來。

上個月月底,黃仁勛在接受彭博電視采訪時表示,目前AI芯片供給緊張的情況正在得到緩解。

他在采訪中表示:“我們預計第三季度的供應量將超過第二季度,第四季度的供應量將超過第三季度,明年第一季度的供應量又將超過第四季度。所以我認為,我們明年的供應狀況將比今年有很大改善。”

如果這是真的,那么在不久的將來,黃仁勛終于可以少承受一些來自那些情緒激動的客戶的壓力了。(財富中文網)

譯者:樸成奎

Nvidia boss Jensen Huang is starting to feel like Atlas with the weight of the world—or at least AI—bearing down squarely on his shoulders.

The CEO and founder of the $2.9 trillion semiconductor giant spoke openly on Wednesday about the tension he’s feeling, offering a glimpse into the pressure he faces to crank up the supply of microchips capable of training the latest AI systems like the successor to OpenAI’s GPT-4.

Customers see his products from the perspective of a player in a zero-sum game—each chip they receive means an advantage for them as well as a disadvantage for rivals who struck out. Huang’s job is to walk this tightrope, balancing the allocation of supply as best he can in order not to endanger client relationships.

“Delivery of our components—and our technology, and our infrastructure and software—is really emotional for people, because it directly affects their revenues, it directly affects their competitiveness,” he told a tech conference hosted by Wall Street investment bank Goldman Sachs.

What Huang exactly meant by “emotional” is unclear, and Nvidia declined to comment further when reached by Fortune. But one thing is certain: Customers—especially the three main cloud hyperscalers, Microsoft, Google, and Amazon, which each require a vast supply—realistically have nowhere else to turn. Nvidia controls 90% of the market.

Speed is everything in the AI race

As founder and CEO, Huang takes his responsibility to key customers personally. In April, he hand-delivered the world’s first DGX server equipped with its upgraded Hopper series AI training chip, the new H200, to OpenAI chief executive Sam Altman and president Greg Brockman.

And in his quest to topple OpenAI from the industry summit, Elon Musk recently revealed plans to purchase 50,000 H200s over the next few months to double the compute at his xAI training cluster in Memphis, where his rival AI model, Grok-3, is currently in training.

“Our fundamental competitiveness depends on being faster than any other AI company. This is the only way to catch up,” Musk explained in a recent social media post. “When our fate depends on being the fastest by far, we must have our own hands on the steering wheel, rather than be a backseat driver.”

That’s why he was willing to risk the ire of Tesla shareholders after allocating Nvidia chips to xAI that should have gone to training the carmaker’s self-driving software system, FSD. It also explains how xAI was able to bring online the largest single compute cluster in the world, powered by 100,000 Nvidia H100 graphic processing units, in the span of just three months.

Whether Musk is a preferred customer is not known, but Nvidia has revealed that just four data center clients were responsible for nearly half of its Q2 top line revenue.

“If we could fulfill everybody’s needs, then the emotion would go away, but it’s very emotional, it’s really tense,” Huang told the Goldman conference on Wednesday. “We’ve got a lot of responsibility on our shoulders and we try to do the best we can.”

Supply constraints set to ease going forward

Huang is not being facetious. At the end of last month, Nvidia posted fiscal second-quarter results that Wedbush tech analyst Dan Ives called nothing short of “the most important tech earnings in years.”

One of the core concerns that both investors and customers were most keen to hear addressed included any additional information on the rollout and ramp-up of Blackwell, the next series of AI chips after Hopper, following reports of delays.

During the investor call, Huang confirmed changes had to be made to the production design template, or “mask,” to improve the yield of chips printed on each silicon wafer. Nonetheless, he insisted he would still be able to ship several billions of dollars’ worth of Blackwell processors before the fiscal fourth quarter ends in late January.

Unlike integrated device manufacturers like Intel or Texas Instruments, Nvidia outsources all semiconductor fabrication to dedicated foundries that specialize in production technology, primarily TSMC. The Taiwanese giant leads the industry when it comes to efficiently miniaturizing transistors, the building blocks of the logic chips printed on each wafer.

That means, however, that Nvidia cannot quickly reply to demand spikes, especially since these chips go through months of complicated process steps before they are fully fabricated.

Pressed about the issue, Huang told Bloomberg Television late last month that constraints were easing.

“We’re expecting Q3 to have more supply than Q2, we’re expecting Q4 to have more supply than Q3, and we’re expecting Q1 to have more supply than Q4,” he said in the interview. “So I think our supply condition going into next year will be a large improvement over this last year.”

If true, then Huang can finally look forward to fewer tense moments with emotional customers in the not too distant future.